В наше время, когда интернет доступен практически в любой момент, иногда возникает необходимость скачать сайт целиком. Зачем это нужно? Причины могут быть разные: и желание сохранить важную информацию на будущее, и необходимость получить доступ к нужным данным при отсутствии доступа в сеть, и возможность ознакомиться с тем, как сверстаны страницы. Могут быть и другие резоны. Важно знать, как выполнить эту задачу, и далее мы покажем несколько способов как сделать копию сайта для последующего его использования в оффлайн режиме.

Онлайн-сервисы

Как несложно догадаться из названия – это специальные сайты, с помощью которых можно скачать другие сайты из интернета. Преимущество данного подхода в том, что не нужно устанавливать дополнительных программ, и, соответственно, не важно какая операционная система установлена. Вроде бы всё классно – вставил имя сайта, нажал скачать, и получаешь готовый архив. Но на деле всё оказалось не настолько радужным.

Недостаток сервисов в том, что их мало, а те что есть, работают так себе, либо просят денег. Лично у меня ни разу не получалось скачать даже одностраничный сайт. Сервисы показывали процесс загрузки и зависали. Но тем не менее, список прилагаю:

- WebSiteDownloader — позволяет, якобы, выгрузить сайт в архиве, англоязычный

- R-Tools — платный с тарифной сеткой. На момент написания работал плохо, https не поддерживается, скаченный сайт открылся криво. Проект развивается, есть демо на 25 страниц.

В общем у меня сложилось впечатление, что эти сервисы либо глючат, либо грузят не совсем то, что хотелось бы, либо годятся только для маленьких сайтиков.

Скачать сайт целиком – зачем это нужно?

Нередко возникает необходимость скачать сайт целиком, чтобы можно было просматривать его в режиме offline. Например, если на сайте много текстовой информации, проще скачать его полностью, чем создавать скриншот каждой отдельной страницы. Это может быть полезно, если необходимо скачать документацию, содержащую 500-1000 веб-страниц.

Также необходимость скачать сайт целиком возникает у программистов, а именно у тех, кто занимается frontend-разработкой. Благодаря этому специалисту не нужно каждый раз заходить на сайт, чтобы увидеть, как именно сверстаны его страницы. Он может скачать сайт и просматривать его в режиме offline.

Программа WinHTTrack WebSite Copier

Всё самое нормальное — платное, но есть варианты. Бесплатное решение — программа WinHTTrack WebSite Copier. Хотя это ненашенский продукт, русский язык имеется, его нужно выбрать после установки программы.

Вы можете посмотреть видео или читать дальше статью:

Пользоваться программой довольно легко, нам в этом поможет «мастер». После запуска программы отображается дерево папок и файлов слева, и приглашение мастера справа. Дерево нужно только для того чтобы открыть ранее сохранённый проект. Нажимаем «Далее» чтобы начать новый проект или возобновить прерванную закачку:

Вводим любое название и путь для сохранения сайта. Путь по умолчанию «C:\Мои Web Сайты» лучше поменять на «C:\Downloads»:

На третьем шаге нужно ввести домен. Для примера, я буду скачивать свой сайт it-like.ru. Тип проекта можно выбрать «Загрузить сайт(ы)», если это новый проект, или «Продолжить прерванную загрузку», если нужно докачать сайт. Вариант «Обновить существующую закачку» полезен для тех, кто уже имеет копию сайта, но хочет её обновить до последней.

Здесь же можно задать дополнительные параметры, которые могут сократить время загрузки. По умолчанию можно ничего не менять, программа и так отработает нормально. Но всё же рекомендую обратить внимание на некоторые параметры:

- Фильтры. Вы можете ограничить тип файлов для закачки. Например, запретить или разрешить скачивание видео или архивов (ZIP, RAR, CAB). По умолчанию включены картинки png, jpg, gif, файлы стилей css и скрипты js.

- Ограничения. Задайте максимальную глубину сканирования сайта. Глубина – это количество переходов по ссылкам со стартовой страницы. Например, если стартовой является главная страница сайта, а глубина равна 2, то программа скачает первый уровень, т.е. главную страницу, и страницы на которые есть ссылки с главной, и всё. Если задать глубину 3, то будут скачены более глубокие страницы. Оптимальным является 3-4 уровня.

- Линки. Поставьте галочку «Получить вначале HTML файлы!», это позволит сначала выкачать основной текстовый контент сайта, а затем уже картинки и другие файлы.

Идём дальше. На четвёртом шаге можно позволить автоматически устанавливать интернет-соединение и разрывать его по окончании закачки. Также можно выставить автоматическое выключение компьютера, по окончании работы (галочка «Shutdown PC when finished»).

Нажимаем «Готово» и идём за чашечкой кофе, пока WinHTTrack WebSite Copier работает за нас.

Готовый сайт можно открыть двумя способами.

- из папки, в которую сохраняли проект, кликнув по файлу index.html. В этом случае откроется страница со списком всех проектов. Нужно выбрать интересующий.

- из папки с именем самого проекта, кликнув по файлу index.html. В этом случае сразу откроется сайт.

Ручное сохранение страниц

Это самый востребованный и легкий вариант для скачивания сайта целиком на компьютер. Некоторые слышали о таком варианте, но не было причин воспользоваться им.

Для этого достаточно нажать одновременно клавиши «Ctrl»+«S», в открывшемся окне, необходимо изменить название страницы, которую хотите сохранить и выбрать папку, где она должна находиться.

Кажется проще некуда? Этот вариант с небольшим недостатком, у нас есть возможность сохранить только одну страницу, а на сайте страниц много.

Этот способ отличный, если сайт состоит только с одной страницы, а если их больше? В этом случае необходимо сохранять каждую страницу по отдельности, что займет много времени.

Этот вариант для тех, кто не знаком с главными правилами скачивания сайта.

Offline Explorer

Платная программа-комбайн, есть демо. Из явных отличий от WinHTTrack:

- встроенный Web-browser и Web сервер для локального предпросмотра;

- распознаёт и загружает ссылки из HTML файлов, Java- и VB- скриптов, классов Java, Macromedia Flash (SFW), CSS, XML/XSL/DTD, TOC, PDF, M3U, AAM, RealMedia (SMIL, RAM, RPM) и MS NetShow Channel (.NSC) файлов;

- поиск по загруженным сайтам;

- экспорт в различные форматы (в т.ч. для записи сайтов на CD);

- удаление скриптов со страниц web.archive.org.

Интерфейс покажется более замороченным, но ничего сложного в нём нет. Запускаем мастер:

Выбираем один из 12 шаблонов:

Например, шаблон «Download only one page with images and scripts» заточен для загрузки только одной страницы. Если не знаете какой выбрать, то пусть будет «Default Template». Далее вводим нужный сайт, любое название проекта и путь к папке на диске:

Нажимаем «Дальше» и выходим из мастера. Должен начаться процесс скачивания, но если ничего не происходит, тогда ткните кнопку «Продолжить»

По окончанию загрузки придёт уведомление на рабочий стол.

Из платных, ещё можете попробовать некогда легендарную программу Teleport Pro (на английском), но по-моему за неё просят намного больше, чем она стоит, да и устарела уже.

Таблица: общее описание

| Название | Описание | Распространение |

| Site2Zip | Сайт, с простым и понятным интерфейсом на русском языке, сайт загружается в два клика. Без регистрации. | Бесплатно |

| Webparse | Интересный инструмент для сознания оффлайн версии сайта, Удобный и простой в использовании. Необходима регистрация. Есть мобильная версию сайта. | Бесплатно (1 скачивание) |

| Web2PDFConvert | Данный сервис может конвертировать отдельные страницы в PDF, JPG, PNG форматы. Очень удобно когда нужно сохранить рецепт или какое-нибудь руководство. | Бесплатно |

| WinHTTrack | Программка позволяет делать копии сайтов для просмотра в оффлайн режиме. Есть русская версия программы. | Бесплатно |

| Cyotek WebCopy | Мощный инструмент для загрузки сайтов на ваш компьютер | Бесплатно |

| Teleport Pro | Еще один крутой инструмент для загрузки сайтов как полностью так и отдельных его разделов на ваш ПК или внешний диск. | Бесплатно (40 запусков) Цена: $50 |

| Offline Explorer | Хорошая программа позволяющая делать до 500 одновременных копии сайтов. Очень широкий функционал с автоматизированными процессами. | Бесплатно (30 дней) Цена: 1500 руб. |

| Webcopier | Браузер для загрузки и просмотра сайтов в оффлайн режиме | Бесплатно (15 дней) Цена: $30 |

Какие есть ограничения у копий

Хочу внести ясность, что скопированный проект, даже если он точь-в-точь будет выглядеть как оригинал, это не означает что будут работать все функции. Не будет работать функционал, который исполняется на сервере, т.е. различные калькуляторы, опросы, подбор по параметрам — работать не будут 99%. Если функционал реализован с помощью Javascript, то будет работать.

Но .php скрипты скачать с сервера НЕВОЗМОЖНО, вообще НИКАК. Также не будут работать формы обратной связи и подачи заявок без ручных доработок, кстати DollySites делает это. Учтите, что некоторые сайты имеют защиту от скачивания, и в таком случае вы получите пустую страницу или сообщение об ошибке.

Итог

Скопировать любой сайт в 2022 году может абсолютно каждый пользователь, который даже не знает про программирование, код и прочее — для этого есть широкий выбор сервисов. Они отлично решают вопрос скачивания одностраничных лендингов, сохраняя их работоспособность, но далеко не всегда могут справиться с сложными сайтами.

Если вам нужен качественный сайт или его копия, то рекомендуем все же обратиться к специалистам — тогда значительно повысится вероятность, что все элементы будут корректно работать, сайт — выполнять свою задачу, а трафик — приносить вам деньги.

Чтобы не было сюрпризов, обязательно проверяйте работоспособность сайта перед работой со всех устройств!

Предыдущий пост Назад Следующий пост Вперед

Продолжение таблицы сравнения программ по созданию оффлайн-копий сайтов.

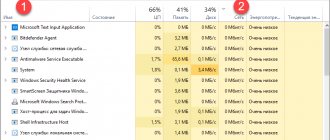

| Название программы | Поддерживаемые технологии | Настраиваемая фильтрация | Операционная система | Версия | Год выпуска | Стоимость |

| A1 Website Download | + | Windows, Mac OS X | от 39 уе | |||

| BackStreet Browser | Windows | 3.2 | 2011 | 19 уе | ||

| Cyotek WebCopy | очень много визуальных настроек и режимов | + | Windows | 1.1.1.4 | 2016 | бесплатен |

| Darcy Ripper | кроссплатформенный | бесплатен | ||||

| GetLeft | — | Windows (with Tcl/Tk), Linux, Mac OSX | 2.5 | бесплатен | ||

| GNU Wget | Linux | бесплатен | ||||

| HTTrack | кроссплатформенный | бесплатен | ||||

| Local Website Archive | — | Windows | 29,95 евро | |||

| Offline Downloader | Windows | 4.2 | 29,95 уе | |||

| Offline Explorer | все | + | Windows | от 60 уе | ||

| QuadSucker/Web | Windows | 3.5 | 2007 | бесплатен | ||

| SurfOffline | CSS, Flash, HTTPS, JS | + | Windows | 29,95 уе | ||

| Teleport Pro | HTML5, CSS3, and DHTML | + | Windows | 1.72 | 2015 | 49,95 уе |

| Visual Web Ripper | AJAX | + | Windows | 3.0.16 | 2016 | 349уе |

| Web Content Extractor | + | Windows | 8.3 | 2016 | 49 уе | |

| Web2Disk | Windows | 39,95 уе | ||||

| WebTransporter | http | + | Windows | недоступна | ||

| WebZIP | Windows | 7.1.2.1052 | 2008 | 39,95 уе |

GetLeft

Этот граббер с открытым исходным кодом существует уже давно, и на это есть веские причины. GetLeft — это небольшая утилита, позволяющая загружать различные компоненты сайта, включая HTML и изображения.

GetLeft очень удобен для пользователя, что и объясняет его долговечность. Для начала просто запустите программу и введите URL-адрес сайта, затем GetLeft автоматически анализирует веб-сайт и предоставит вам разбивку страниц, перечисляя подстраницы и ссылки. Затем вы можете вручную выбрать, какие части сайта вы хотите загрузить, установив соответствующий флажок.

После того, как вы продиктовали, какие части сайта вы хотите зазрузить, нажмите на кнопку. GetLeft загрузит сайт в выбранную вами папку. К сожалению, GetLeft не обновлялся какое-то время.

Спасибо, что читаете! Подписывайтесь на мои каналы в Telegram, Яндекс.Мессенджере и Яндекс.Дзен. Только там последние обновления блога и новости мира информационных технологий.

Также, читайте меня в социальных сетях: Facebook, Twitter, VK, OK.

SiteSucker

Если вы твердо придерживаетесь экосистемы Apple и имеете доступ только к Mac, вам нужно попробовать SiteSucker. Программа, получившая такое название, копирует все файлы веб-сайта на жесткий диск. Пользователи могут начать этот процесс всего за несколько кликов, что делает его одним из самых простых в использовании инструментов. Кроме того, SiteSucker довольно быстро копирует и сохраняет содержимое сайта. Однако помните, что фактическая скорость загрузки будет зависеть от пользователя.

К сожалению, SiteSucker не лишен недостатков. Во-первых, SiteSucker — платное приложение. На момент написания этой статьи SiteSucker стоит $4.99 в App Store. Кроме того, SiteSucker загружает каждый файл на сайте, который может быть найден. Это означает большую загрузку с большим количеством потенциально бесполезных файлов.

Как полностью скопировать страницу сайта или сайт с исходным кодом?

Ответ прост — COPYRON.RU. Мы для Вас предоставляем возможность сделать заказ на рип сайта несколькими способами.

Самый оперативный метод. 24/7 онлайн. Оперативная обратная связь. Всегда можете задать вопрос.

Самый надежный. Пишите нам на электронную почту — всегда на связи, и Ваше письмо не затеряется.

Сделав заказ через сайт, Вы получите возможность отслеживать выполнение заказа с помощью трек номера.

Мануал по копированию сайта

Отслеживание Вашего заказа можно смотреть по «номеру заказа», который будет Вам выдан автоматически при заказе. Если сайт небольшой, ссылку на архив получите в течении 30 минут — 1 часа. Если сайт большой, то мы Вас предупредим, и сообщим сколько приблизительно по времени ожидать. В любом случае — на связи.

Первый метод — своими руками

Самый традиционный вариант — сделать своими руками. Никакие сторонние инструменты, кроме рук и браузера, не понадобятся. Для начала найдите интересующий вас сайт. Я для примера возьму собственный блог. Перехожу на главную страницу. В любой области кликаю правой кнопкой мыши. В открывшемся меню выбираю пункт «Сохранить страницу как…»:

Процесс сохранения длится несколько секунд. На выходе получаю файл главной страницы и папку со всеми составляющими элементами. Там находятся картинки, PHP и JS файлы и стили. Файл с разрешением HTML можно открыть с помощью блокнота для просмотра исходного кода.

Если вы думаете, что сохранённые файлы можно смело натягивать на свой ресурс, то сильно ошибаетесь. Это — очень сырой вариант. Скорее, он пригоден только для просмотра исходного кода страницы, что можно сделать в окне браузера без сохранения. Пользоваться этим методом я не рекомендую, так как толку от него ноль и как перенести его на WordPress (к примеру), вам никто не расскажет (такой возможности просто нет).

Почему вы хотите это сделать?

Вопреки распространенному мнению, не все в Интернете существует всегда. Сайты закрываются, подвергаются цензуре, приобретаются, перепроектируются или просто теряются. Эта идея исходит от сообщества накопителей данных в Reddit, где процесс создания архивов для развлечения не является чем-то новым. Хотя мы не можем предсказать или предотвратить катастрофическое событие на нашем любимом веб-сайте, мы, несомненно, можем сохранить его в нынешнем виде .

Есть много возможных применений и причин, по которым можно скачать весь сайт. Неважно, является ли целевой сайт вашим или нет. На заметку, будьте осторожны с тем, что вы загружаете Возможно, вы хотите сохранить эпоху сайта с особым дизайном. Может быть, вы хотите взять информативный веб-сайт с собой в место без интернета. Этот метод может гарантировать, что сайт останется с вами.